- A

- A

- A

- АБB

- АБB

- АБB

- А

- А

- А

- А

- А

- Национальный исследовательский университет «Высшая школа экономики»

- Факультет гуманитарных наук

- Школа лингвистики

- Новости

- Курица не птица: мастер-класс по снятию лексической неоднозначности

-

Школа

- О школе

- Сотрудники

- Семинары

-

Исследовательские подразделения

-

- Международная лаборатория языковой конвергенции

- Центр «Русский как иностранный»

- Центр цифровых гуманитарных исследований

- Центр языка и мозга

- Лаборатория по формальным моделям в лингвистике

- Лаборатория «Корпусные исследования»

- Лаборатория языков Кавказа

- Лаборатория учебных корпусов

- Лаборатория теоретической и полевой фольклористики

- Лаборатория социогуманитарных исследований Севера и Арктики

-

-

Проекты

-

Проекты сотрудников

-

Проекты студентов и аспирантов

-

Завершённые проекты

- Некомпозициональные конструкции в эритажном русском

- Компьютерные и лингвистические ресурсы для поддержки шугнанского языка

- Лингвоспецифическая разметка китайских текстов в Русско-китайском параллельном корпусе НКРЯ

- Цифровой архив: создание корпуса журнала "Отечественные записки"

- Создание лингвокультурологического подкаста о России для иностранцев «Yellow Blue Bus» (Я люблю вас)

- База данных русских идиом

- Компьютерные и корпусные инструменты для иранистических исследований

- Русский разговорный клуб

- Шугнанские глаголы в типологическом освещении

- Создание академического онлайн-словаря персидского языка

-

- Международное сотрудничество

- Экспедиции

- Ресурсы

- Препринты

- Наша книжная полка

-

Образовательные программы

Адрес: 105066, г. Москва,

Старая Басманная ул., д. 21/4

Телефон: +7 (495) 772-95-90 доб. 22734

E-mail: ling@hse.ru

Редакторы сайта — Наталья Борисовна Пименова, Максим Олегович Бажуков, Константин Евгеньевич Сатдаров

- Международная лаборатория языковой конвергенции

- Лаборатория «Корпусные исследования»

- Лаборатория по формальным моделям в лингвистике

- Лаборатория языков Кавказа

- Лаборатория социогуманитарных исследований Севера и Арктики

- Научно-учебная лаборатория учебных корпусов

- Центр «Русский как иностранный»

- Научно-учебные группы

- Каталог проектов по компьютерной лингвистике

- Проекты, поддерживаемые грантами

- Русский язык для всех

- Лингвистический кружок для школьников

- Лингвистика в Центре открытого образования

Школа лингвистики была образована в декабре 2014 года. Сотрудники школы преподают на образовательных программах по теоретической и компьютерной лингвистике в бакалавриате и магистратуре. Лингвистика, которой занимаются в школе, — это не только знание иностранных языков, но прежде всего наука о языке и о способах его моделирования. Научные группы школы занимаются исследованиями в области типологии, социолингвистики и ареальной лингвистики, корпусной лингвистики и лексикографии, древних языков и истории языка. Кроме того, в школе создаются лингвистические технологии и ресурсы: корпуса, обучающие тренажеры, словари и тезаурусы, технологии для электронного представления текстов культурного наследия.

Жидкова Е. Г., Занадворова А. В., Какорина Е. В. и др.

Ч. 1: А-И. Вып. 6: дополнительный. Институт русского языка им. В.В. Виноградова РАН, 2026.

Russian Linguistics. 2026. Т. 50.

В кн.: Толковый словарь русской разговорной речи. Вып. 6, дополнительный, часть 1: А-И. Ч. 1: А-И. Вып. 6: дополнительный. Институт русского языка им. В.В. Виноградова РАН, 2026. С. 194-285.

arxiv.org. Computer Science. Cornell University, 2024

Курица не птица: мастер-класс по снятию лексической неоднозначности

Очередной мастер-класс для студентов магистерской программы «Компьютерная лингвистика» провели научный сотрудник лаборатории нейролингвистики НИУ ВШЭ Анастасия Лопухина и разработчик компании ScrapingHub Константин Лопухин. Занятие было посвящено применению дистрибутивных семантических моделей для автоматического определения значения многозначных слов.

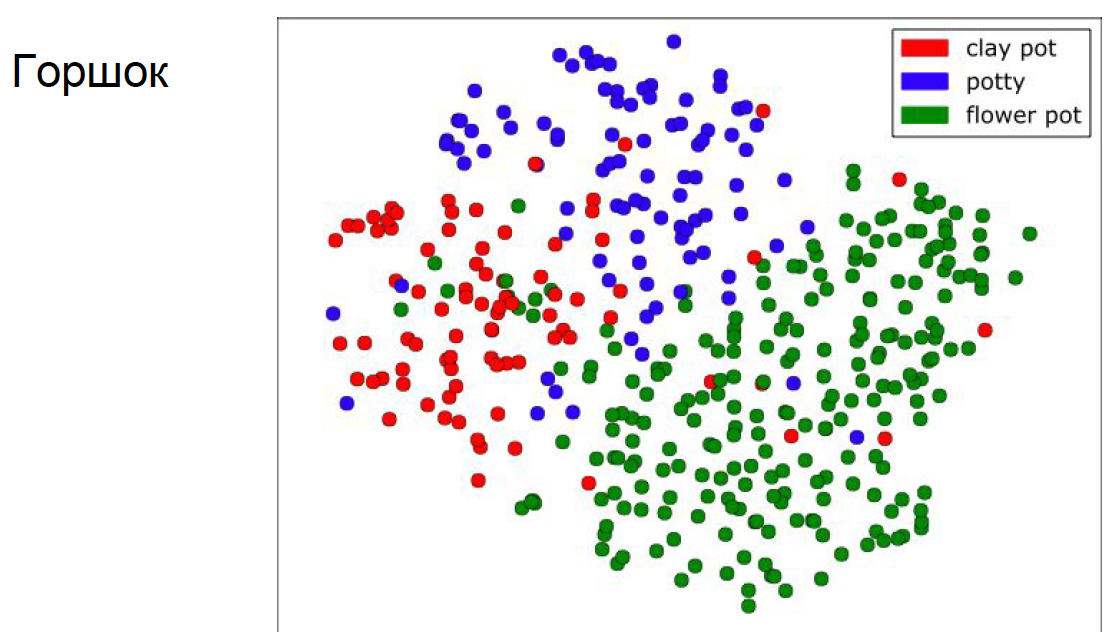

Дистрибутивная семантика опирается на идею о том, что значения слов определяется теми контекстами, в которых они употребляются («You shall know a word by the company it keeps»). Для слов, у которых есть одно выраженное значение, такие модели действительно работают хорошо: лампа в них оказывается очень близкой к светильнику, помидор к огурцу и т.д. Однако многозначные слова и омонимы создают трудности: ведь если лук в части текстов сочетается со словами овощ, есть, продукты, хлеб, а в части — со словами стрелы, натягивать, стрелять, арбалет, то дистрибутивный семантический вектор получится смешанным, далеким и от оружия, и от еды.

Автоматически разделить значения непросто, но нужно. Во-первых, без этого трудно применять многие другие средства компьютерного анализа текста, во-вторых, эти данные востребованы лингвистами, в-третьих, они нужны лексикографам, чтобы понять, какие значение в каком порядке стоит указывать в словарях. Последний момент особенно важен, т.к. с анализ показывает, что значения, указанные первыми в словаре, иногда оказываются очень редкими, низкочастотными, а частотные значения, наоборот, могут указываться в конце статьи или игнорироваться. Для некоторых слов наиболее частотными вообще оказываются метафорические значения (бешенство, бред, брешь, веха). К счастью, дистрибутивные модели можно адаптировать для работы с несколькими значениями одного слова. Именно о такой адаптации и рассказывали Анастасия и Константин.

В работе с многозначными словам традиционно выделяют две задачи. Первая из них — Word sense disambiguation, то есть снятие лексической неоднозначности, предполагает,наличие нескольких заранее известных значений у слова (например, полученных из словаря или WordNet). При решении такой задачи с помощью дистрибутивных моделей можно создать для разных значений обучающие корпуса с соответствующими контекстами, после чего обучить модели на них и получить вектора отдельных значений (например, лук-растение и лук-оружие).

Лопухина Анастасия Александровна

- О ВЫШКЕ

- Цифры и факты

- Руководство и структура

- Устойчивое развитие в НИУ ВШЭ

- Преподаватели и сотрудники

- Корпуса и общежития

- Закупки

- Обращения граждан в НИУ ВШЭ

- Фонд целевого капитала

- Противодействие коррупции

- Сведения о доходах, расходах, об имуществе и обязательствах имущественного характера

- Сведения об образовательной организации

- Людям с ограниченными возможностями здоровья

- Единая платежная страница

- Работа в Вышке

- ОБРАЗОВАНИЕ

- Лицей

- Довузовская подготовка

- Олимпиады

- Прием в бакалавриат

- Вышка+

- Прием в магистратуру

- Аспирантура

- Дополнительное образование

- Центр развития карьеры

- Бизнес-инкубатор ВШЭ

- Образовательные партнерства

- Обратная связь и взаимодействие с получателями услуг

-

http://www.minobrnauki.gov.ru/

Министерство науки и высшего образования РФ

-

https://edu.gov.ru/

Министерство просвещения РФ

-

http://www.edu.ru

Федеральный портал «Российское образование»

-

https://elearning.hse.ru/mooc

Массовые открытые онлайн-курсы

- © НИУ ВШЭ 1993–2026 Адреса и контакты Условия использования материалов Политика конфиденциальности Карта сайта

- Редактору